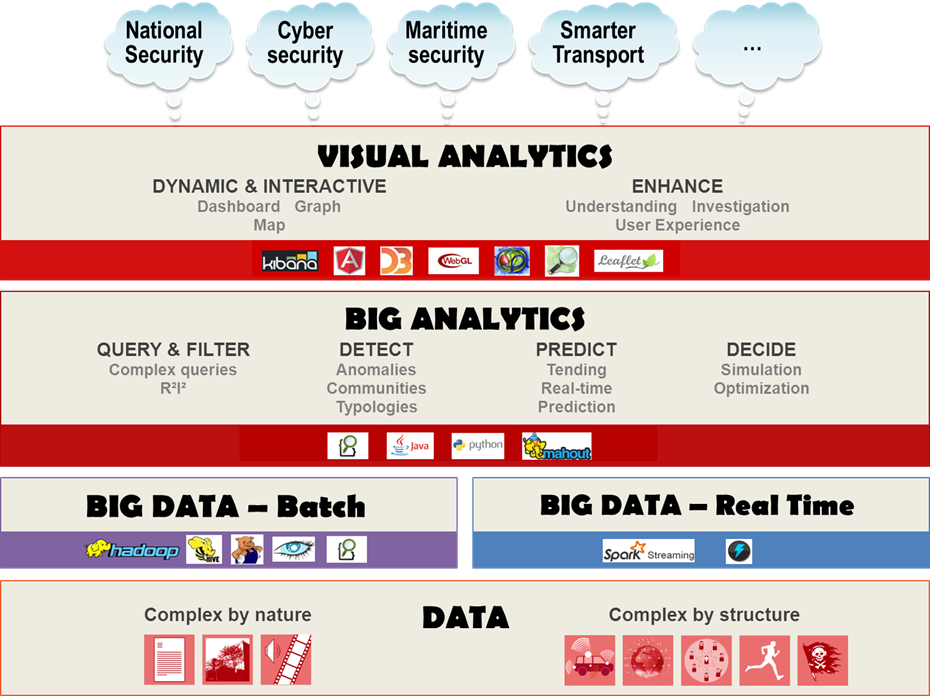

L’approche de Thales est structurée selon les trois axes du Big data (problématiques de gestion/stockage des données), du Big Analytics (problématiques de traitement, d’enrichissement et de valorisation données) et du Visual Analytics (problématiques d’exploitation et de visualisation interactive des données à partir d’algorithmes d’analyse parallélisables et/ou linéarisables, pour répondre au besoin d’exhaustivité), lesquels sont très fortement imbriqués.

Pour le Big data, le fait avéré est que jamais auparavant autant de données n’avaient été produites, par les systèmes mobiles (réseaux sociaux, communications téléphoniques, etc.) mais également par les caméras de sécurité, les satellites, les capteurs chimiques ou électromagnétiques ainsi que les réseaux sans fil toujours plus nombreux. Trouver de nouveaux modes de stockage et utiliser de nouveaux principes d’indexation des données dans des architectures est devenu indispensable. Cela s’est fait sous la direction des grands acteurs du web - Google, Facebook, Amazon, Twitter, etc., les processus de stockage de l'information se sont adaptés à la montée en charge, en termes de volumétrie, des données à enregistrer. Les modes de stockage NoSQL – « Not only SQL » permettent d'aller au-delà des performances des bases de données relationnelles actuelles, adressables via SQL, donnant lieu à une nouvelle approche architecturale.

En ce qui concerne le Big Analytics, les algorithmes à utiliser sont très différents suivant que l’on connaisse (même partiellement) ou non, la structure de la population à analyser.

Dans le premier cas, on peut avoir recours à des processus statistiques de type approches par sondages ou approches par réduction de dimensions, qui n’impliquent pas le traitement exhaustif de l’ensemble (souvent conséquent) des données collectées. On parle alors de « Big Analytics par extension »). D’autres parlent d’approches dites « Hypotheses driven mode » car, effectivement, on suppose dans ce cas une pré-connaissance de certains phénomènes liés à la population analysée (sous-structures en classes, distributions de lois sous-jacentes[1], etc.) ce qui simplifie considérablement les calculs ; on étend ici ce qui était déjà pratiqué en « Data Mining » dans les années 1990-2000.

Dans le deuxième cas (un cas d’école en est l’étude des « grands réseaux » : réseaux sociaux, réseaux de distribution, réseaux de communications etc.), la pré-connaissance intrinsèque de la population à analyser est quasi impossible, les algorithmes doivent donc travailler en mode quasi exhaustif et, de fait, exigent d’être parallélisés ou linéarisés pour leur permettre cette compatibilité à la montée en charge (scalabilité). On parle dans ce cas de « Big Analytics intrinsèque » ou de « Data driven mode ».

Cette classification en deux sous-thématiques – « Data driven » et « Hypothesis driven » - est très clivante car elle se positionne au-dessus de la typologie et du lexique des termes rencontrés dans l’univers Big Analytics à savoir : apprentissages supervisés et non supervisés, approches par algorithmes heuristiques génétiques, réseaux de neurones auto-apprenants, clustering relationnel etc.

Thales, au travers de son laboratoire CeNTAI en charge des activités Big data, développe de tels algorithmes d’apprentissage supervisé (régression, arbre de décision, SVM, réseaux de neurones standard, Expectation Maximization, Classification, etc.) et non supervisé (auto-encodeurs, clustering, théorie des copules, chaînes de Markov, réseaux auto-apprenants, etc. ).

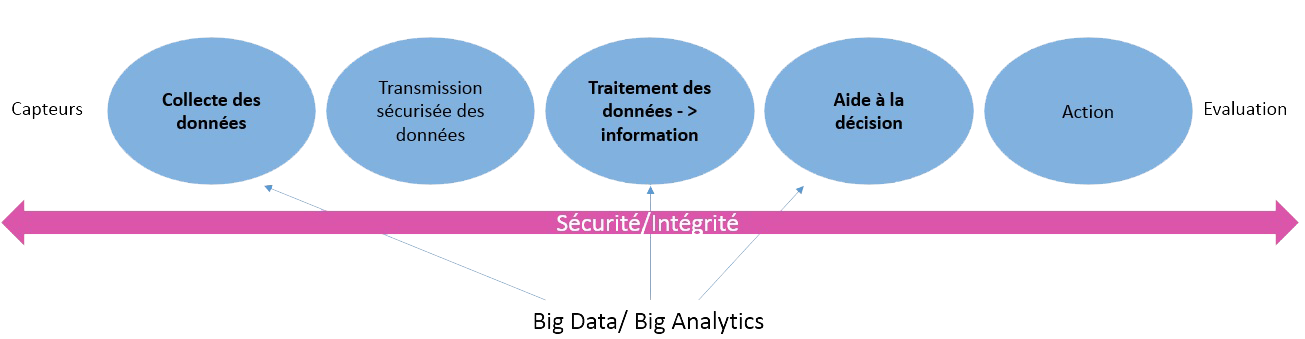

Une plate-forme générique, composée d’une architecture Big data fondée sur des technologies NoSQL et sur Elastic Search, permet le stockage et l’accès en mode batch et temps réel des données massives hétérogènes et dynamiques issues de systèmes d’information, d’algorithmes Big Analytics et Visual Analytics principalement dédiés à la fusion d’informations, au requêtage intelligent, à l’analyse typologique, à la détection des communautés, à la détection et l’investigation d’anomalies et de signaux faibles, à la prédiction et à l’aide à la décision.

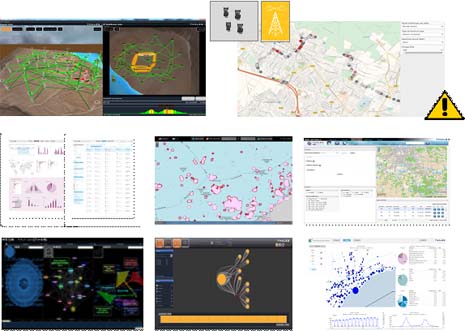

Des chaînes de traitement métier ont été implémentées en collaboration étroite avec les activités de Thales et ses clients, notamment dans les domaines de la cybersécurité, des réseaux, de la sécurité maritime, du contrôle aux frontières, de la guerre électronique et du transport.

En tant que grand opérateur d’infrastructures critiques, Thales bénéficie de l’accès aux données et aux systèmes de ses clients.

Cet avantage associé à la capacité de Thales de coupler des expertises avancées dans les domaines du Big Analytics, de la sécurité et du Cloud sécurisé avec la connaissance métier fait de l’entreprise un acteur unique sur le marché.